SSD, HDD, Flash, eMMC im Vergleich - Alles zu PCIe, NVMe, USB Type C, Thunderbolt & Co.

Die technische Realisierung persistenter Speicher blickt auf eine recht lange Geschichte zurück. Vergleichsweise prominent sind etwa Lochkarten. ROM-Speicher lassen sich hingegen meist nicht respektive nur einmal beschreiben.

Ein weiteres, technisch bereits wesentliches fortschrittliches System war die gezielte Ummagnetisierung von Ringkernen. Auch nach Wegnahme der Spannungsquelle bleibt die Magnetisierung erhalten und ließ sich auslesen. Das Vorzeichen dieser sogenannten Remanenz repräsentiert dabei den Speicherinhalt (1 oder 0).

Magnetfestplatten

Die klassischen Magnetfestplatten basieren wie die Kernspeicher ebenfalls auf der Magnetisierung einer extrem dünnen Deckschicht (etwa Eisenoxid). Diese ist auf der eigentlichen „Scheibe“ aufgebracht, welche zur Reduktion von Wirbelströmen etwa aus Aluminium oder Glas besteht.

Der sogenannte Schreib-Lesekopf, im Prinzip ein Elektromagnet, schwebt wenige Nanometer über der Festplatte und liest die Magnetisierung der Oberfläche beim Lesen aus und magnetisiert diese beim Schreiben neu. Heute machen sich Hersteller beim Lesevorgang den Riesenmagneto-Widerstand zunutze: Der Lesekopf besteht aus zwei Magnetschichten, von denen eine immer eine konstante Magnetisierungsrichtung beibehält. Die zweite magnetische Schicht lässt sich sehr leicht von der Magnetschicht der Festplatte (und damit den gespeicherten Daten) umpolen. Haben beide durch eine nichtmagnetische Schicht getrennte Magnetschichten die gleiche Ausrichtung, ist der elektrische Widerstand wesentlich geringer.

Da Magnetfestplatten bereits seit den 1950er Jahren genutzt werden, ist die Technik ausgereift. Große Quantensprunge sind – vorsichtig formuliert – aufgrund mechanischer (Fertigungstoleranzen und genaue Ansteuerung) und physikalischen Grenzen nicht mehr zu erwarten, obgleich die Speicherkapazität von 3,5-Zoll-Festplatten inzwischen bei 10 Terabyte liegt.

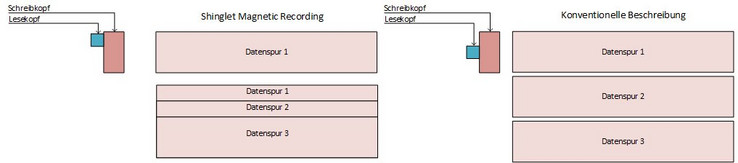

Die maximale Speicherkapazität ist so etwa durch den Superparamagnetismus beschränkt, da die Empfindlichkeit gegenüber thermischer Belastung (und damit die Gefahr eines Datenverlustes) mit der Verkleinerung der einzelnen Datenspuren steigt – schon heute dient die verwendete Gasfüllung (wie neuerdings Helium) nicht nur der Vermeidung von Turbolenzen, sondern auch der effizienten Wärmeleitung. Eine aktuelle Optimierungsmöglichkeit ist das sogenannte „Shinglet Magnetic Recording“: Der zwangsläufig breitere Schreibkopf magnetisiert die einzelnen Datenspuren „überlappend“, der schmale Lesekopf kann den verbleibenden Rest der Datenspur aber problemlos auslesen. Allerdings müssen dann bei einer Datenänderung nachfolgende Spuren umgesetzt werden, weshalb in bestimmten Abständen Lücken gelassen werden. Das nötige Umschreiben hat einen negativen Effekt auf die Schreibgeschwindigkeit.

Die Schreibgeschwindigkeit ist eines der größten Nachteile von Magnetfestplatten: Während sequenzielle Daten im Optimalfall unproblematisch und schnell in einem Rutsch abgefahren werden können, muss bei wahlfreien Zugriffen der Lesekopf häufig bewegt werden, was die Datenrate von bis zu 200 Mbyte/s auf wenige MB/s absenken kann. Aufgrund von Sicherheitsmechanismen sind heutige Festplatten mechanisch weniger stark anfällig, diesbezüglich den SSDs aber ganz klar unterlegen. Vorteilhaft ist hingegen die hohe Speicherdichte und der günstige Preis je GByte.

Sogenannte Hybridspeicher kombinieren eine konventionelle Festplatte mit eingebautem Flash-Speicher. Nach einer gewissen Lernphase werden häufig benutzte Daten (beispielweise Komponenten des Betriebssystems oder Programme) auf den Flash-Speicher abgelegt, was etwa den Programmstart deutlich beschleunigen soll. Angesichts stetig sinkender Preise für SSDs würden wir allerdings eher vom Einsatz einer Hybrid-Festplatte abraten, insbesondere wenn ein Notebook die Installation zweier Datenspeicher erlaubt.

Flash-Speicher

Funktionsprinzip

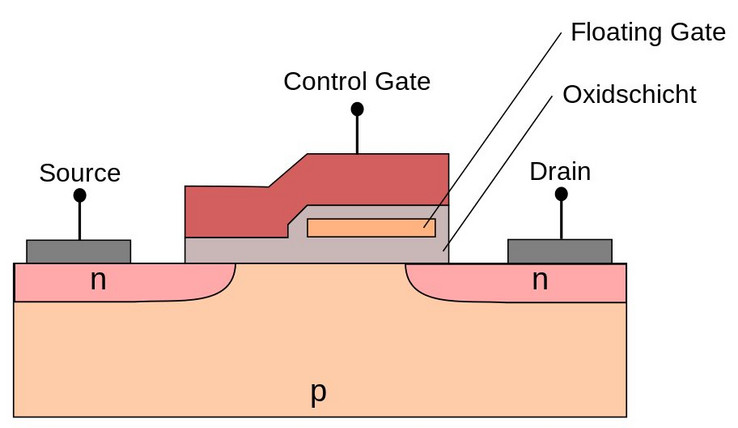

Das Funktionsprinzip basiert im Gegensatz zu Festplatten nicht auf Magnetisierung, sondern auf dem Halten von Spannungen, was im sogenannten Floating Gate geschieht. Befinden sich Ladungsträger im Floating Gate, verändert sich die ausgelesene Spannung im Vergleich zu einem ungeladenen Floating Gate. In Unterschied zu den Magnetfestplatten lassen sich durch unterschiedliche Spannungsniveaus mehr als zwei Speicherzustände darstellen, wobei die zuverlässige Darstellung mehrerer Spannungsniveaus deutlich anspruchsvoller ist – was am ehesten in einer verringerten Geschwindigkeit und Lebensdauer resultiert. Vier Ladungszustände erlauben etwa die Speicherung von zwei Bit in einer Zelle (TLC), acht die Speicherung von drei Bit (MLC).

Das Entladen des Floating Gates ist nicht trivial und erfolgt durch eine hohe negative Spannung am Control Gate, wodurch Elektronen aus dem Floating Gate durch die Oxidschicht in das Substrat tunneln. Dabei kann es zum sogenannten „over erase“ kommen: Dann ist das Floating Gate mit Defektelektronen (positiven Ladungsträgern) besetzt, wodurch dieses selbstleitend werden kann. Selbst bei einer einwandfreien Funktionsweise belastet das Tunneln durch die hohe Spannung die Oxidschicht, welche irgendwann keine einwandfreie elektrische Trennung mehr zwischen Floating Gate und Substrat sicherstellen kann.

NAND- und NOR

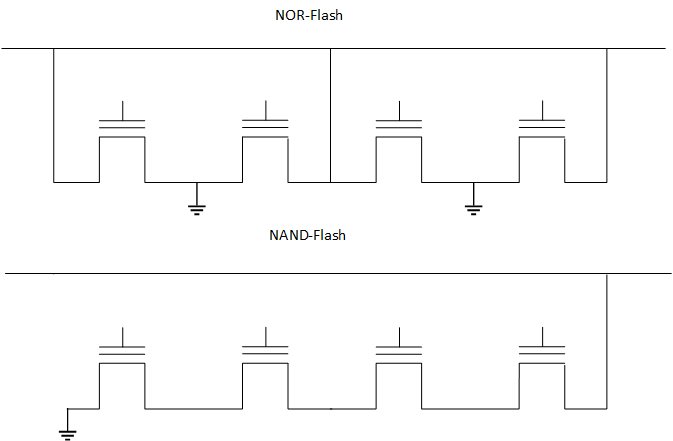

Zweckmäßigerweise sind zahlreiche einzelne Speicherbausteine miteinander verschalten, was die Speicherdichte und damit letztlich auch den Preis verbessert. Sogenannter NOR-Flash ermöglicht durch die parallele Verschaltung einen wahlfreien Zugriff, zum Löschen muss allerdings ein ganzer Block, der aus zahlreichen einzelnen Speicherzellen besteht, gelöscht werden. In der Praxis ist dies jedoch kein relevanter Nachteil. Durch den hohen Preis ist NOR-Flash heute allerdings unbedeutend.

Der heute relevante NAND-Speicher arbeitet mit einer Reihenschaltung der einzelnen Zelle, was die Speicherdichte enorm erhöht, jedoch einen wahlfreien Zugriff ausschließt. Möchte man etwa den Zustand einer einzelnen Zelle erfahren, müssen vorher alle anderen Zellen der Kette leitfähig gemacht werden.

Optimierungen und 3D XPoint

Eine weitere Möglichkeit, die Speicherdichte zu erhöhen, besteht in der gepackten, dreidimensionalen Anordnung der Speicherzellen. Bis zu 42 Lagen ermöglichen Speicherdichten von über 10 TByte im 2,5-Zoll-Format. Eine vertikale statt planare Anordnung soll zudem durch eine breitere Bitleitung Störungen der einzelnen Zellen untereinander erheblich vermindern.

Für dieses Jahr ist von Intel und Micron die sogenannte 3D-XPoint-Technologie angekündigt, welche ohne Transistoren auskommt und durch eine dreidimensionale Anordnung von Speicherzellen an den Kreuzungspunkten von Wort- und Bitleitungen den wahlfreien Zugriff bei gleichzeitig hoher Speicherdichte erlauben soll. Intel spricht von der zehnfachen Kapazität von DRAM bei der tausendfachen Geschwindigkeit von NAND-Flash. Erste Micron-Prototypen erfüllen die hohen Erwartungen allerdings noch nicht.

Über Controller und Hitze

Die Leistung moderner SSDs hängt auch entscheidend vom verbauten Controller ab, welcher die Schnittstelle zwischen den eigentlichen Speicherstellen und dem Computersystem darstellt. Dieser übernimmt nicht nur die Kommunikation, sondern markiert etwa auch beschädigte Speicherblöcke und drosselt bei einer drohenden thermischen Überlastung die Leistung. Die Thermoregulierung ist besonders bei leistungsstarken Flash-Speichern durchaus ein relevanter Faktor zur Leistungsbewertung und stellt auch Anforderungen an die Gehäuselüftung. Zudem nimmt die Leistung nach Phasen hoher Last und geringerem freien Speicherplatz ab – die Höhe des Leistungsverlustes ist ein Qualitätsmaßstab der SSD.

Initiale Bedenken, SSDs würden enorm schnell an Leistung verlieren, haben sich inzwischen in Wohlgefallen aufgelöst, insbesondere durch die Integration von Garbage Collection, TRIM und dem automatischen Verzicht auf Defragmentierung. Ein mahnendes Wort sei jedoch an Entwickler gerichtet: Unnötig häufige Zwischensicherungen können die Anzahl der Schreibvorgänge enorm erhöhen. Im Jahr 2016 wurde etwa bekannt, dass Firefox standardmäßig alle 15 Sekunden eine lokale Sicherungskopie anlegt, innerhalb eines Tages können so über 10 GByte auf die SSD geschrieben werden.

Anbindung von Speichern

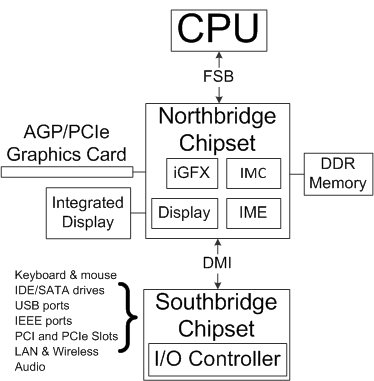

Speicher müssen an die CPU angebunden werden, wobei hier ein klassischer Aufbau mit North- und Southbridge angenommen werden soll – die konkrete Ausgestaltung der internen Verbindungen hängt auch stark von der tatsächlichen Plattform-Architektur ab. Die Verbindung zwischen CPU und den beiden Chipsätzen wird über dedizierte, interne und für den Anwender wenig relevante Datenleitungen wie etwa dem Direct Media Interface und QuickPath (Intel) bzw. HyperTransport (AMD) realisiert.

Wichtig: Die PCIe-Schnittstellen sind (meist) direkter angebunden als andere I/O-Ports. So ist bei Intels Kaby-Lake-Architektur ein PCIe 3.0 x16 Port direkt mit der CPU (welche Northbridge Chips enthält) verbunden, die anderen über den Platform Controller Hub. Es ist auch möglich, dass der schnellste PCIe-Slot an die Northbridge, die übrigen an die Southbridge angebunden sind.

Die Southbridge stellt im klassischen Layout auch unter anderem die IDE-, SATA- und USB-Verbindungen bereit, wobei die maximale Gesamtdaten-Übertragungsrate wiederum durch die Anbindung der Southbridge limitiert ist. Auch die Anzahl der PCIe Lanes ist (dadurch) limitiert, was in der Praxis durchaus zu Problemen führen kann, wenn auf einem günstigen Chipsatz etwa eine oder zwei Grafikkarten, eine PCIe-SSD und noch eine USB-3.1-PCIe-Karte installiert werden soll. Chipsätze unterschiedlicher Hersteller können darüber hinaus für signifikant unterschiedliche Datenraten sorgen.

PCIe-Express

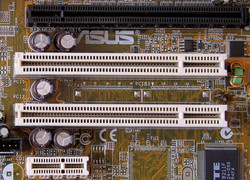

Für den Endverbraucher deutlich wichtiger sind die extern erreichbaren Anschlüsse. PCIe ist insbesondere als Port von Grafikkarten bekannt, dient aber vermehrt auch dem Anschluss von anderen Erweiterungskarten und SSDs.

PCI Express ist vollduplexfähig und basiert auf direkten Verbindungen mit den entsprechenden Geräten, wodurch die Kommunikation nicht von der Datenübertragung anderer PCIe-Geräten gestört wird. Das wohl wichtigste Merkmal: PCIe ist extrem schnell. Der aktuelle 3.0-Standard ermöglicht abhängig von der Anzahl der Lanes (x1-x32) Datenraten von bis zu 31.508 MB/s in jede Richtung, bei vier Lanes bleiben noch maximal 3.938 MB/s übrig.

PCIe-Verbindungen werden aufgrund der hohen Datenrate auch zur Anbindung von M.2- und SATA-Express-Laufwerken genutzt, wobei M.2-SSDs jedoch auch über SATA angebunden werden können. Der M.2-Standard ist insbesondere für Notebooks und kompakte Computersysteme relevant, da die 12, 16, 22 oder 30 Millimeter breiten und zwischen 16 und 110 Millimeter langen Laufwerke eine erhebliche Platzersparnis bieten. So ist es selbst in kleineren Notebooks möglich, eine M.2-SSD und zusätzlich eine 2,5-Zoll-Festplatte unterzubringen.

Eine vergleichsweise neue Entwicklung stellen sogenannte NVME-SSDs dar. Bei NVMe handelt es sich um den Nachfolger des althergebrachten AHCI-Protokolls und sorgt durch ein besseres Zusammenspiel mit der CPU für geringere Latenzen. Die Ressourcen des Prozessors können überdies durch eine von 32 auf 64.000 erhöhte Warteschlange für ausstehende Befehle (Command Que Depth) besser genutzt werden. Auch wenn solch eine Warteschlangelänge eher im Serverbereich vorkommt, sind NVMe auch für Endverbraucher erhältlich.

SATA

Festplatten und einfachere SSD werden hingegen über den SATA-Port angebunden. Die Weiterentwicklung des ATA-Standards überträgt Daten seriell und erlaubt den Wechsel im laufenden Betrieb. Mittels eSATA lassen sich darüber hinaus auch externe Festplatten anbinden, eSATA konnte im Markt aber nie Fuß fassen.

Mit einer Bruttodatenrate von 600 Mbyte/s ist SATA für Festplatten und viele SSDs schnell genug, wobei die Reaktionsfreudigkeit einer SSD allerdings nicht nur von der sequenziellen, sondern auch von der wahlfreien Geschwindigkeit und der geringeren Zugriffszeit herrührt. Für das Gros der Nutzer ist deshalb eine (gute) SATA-SSD völlig ausreichend.

Die Weiterentwicklung in Form von SATA Express basiert wiederum auf PCIe, wobei die Kabelverbindung eine flexible Positionierung der SSD im Gehäuse erlaubt. Die sogenannte SAS-Schnittstelle kommt nahezu ausschließlich im Serverbereich zur Anwendung und ist im Gegensatz zu SATA vollduplexfähig.

USB

Als universelle Schnittstelle für Peripheriegeräte und auch Speicher hat sich in den letzten Jahren USB (Universal Serial Bus) gegenüber dem konkurrierenden FireWire-Anschluss durchgesetzt. USB 3.0 und der aktuelle 3.1-Standard erlauben Bruttodatenraten von 500 und 1.200 Mbyte/s. Allerdings müssen Konsumenten genau hinsehen: USB 3.1 (Gen. 1) erreicht ebenfalls nur 500 Mbyte/s.

Grundsätzlich erlaubt ein bestimmter Steckertyp nicht ohne Weiteres einen Rückschluss auf den verwendeten Standard, so können etwa Smartphones via USB Typ-C angeschlossen werden, aber trotzdem nur mit USB-2.0-Geschwindigkeit angebunden sein.

| Standard | Bruttodatenrate | maximale elek. Leistung |

|---|---|---|

| USB 2.0 | 480 Mbit/s | 2,5 Watt |

| USB 3.0 SuperSpeed oder USB 3.1 Gen 1 | 5 Gbit/s | 4,5 Watt |

| USB 3.1 SuperSpeed+ oder USB 3.1 Gen 2 | 10 Gbit/s | 4,5 Watt |

| USB Typ C | keine Spezifikation der Geschwindigkeit, sondern Steckertyp | 15 Watt 100 Watt (Power Delivery) |

Im Gegensatz etwa zu eSATA können Festplatten über USB gleichzeitig mit Strom versorgt werden. Über Power Delivery können bis zu 100 Watt abgegeben werden, was dann sogar zum Betrieb eines Monitors oder Notebooks genügt.

Dazu kommt, dass über sogenannte Alternate Modes auch Bildsignale etwa via Thunderbolt übertragen werden können. Da auch der HDMI-1.4b-Standard unterstützt wird, lässt sich sogar Fast-Ethernet durchschleifen. Ein Nutzungsszenario könnte etwa ein Monitor sein, der ein Notebook über USB Typ-C lädt, Bildsignale von diesem empfängt und zudem Zugriff auf weitere Peripheriegeräte gibt. Mit dem Ende 2016 verabschiedeten USB Audio Device Class 3 Standard ist zudem die Audioübertragung geplant.

Unangenehme Überraschungen sind jedoch nicht auszuschließen, Medienberichten zufolge kann die Funktionsfähigkeit etwa von Monitoren bei einem zu hohen Energiebedarf eines angeschlossenen Notebooks eingeschränkt werden. Hier bleibt (vorerst) nur der ernüchternde Verweis auf Erfahrungsberichte anderer Nutzer.

Thunderbolt

Thunderbolt wurde 2011 erstmals öffentlich vorgestellt und ist der aktuellen, dritten Revision mit bis zu 5 GByte pro Sekunde das derzeit potentiell schnellste Übertragungsprotokoll, welches ebenfalls auf USB Typ-C als Anschlusstyp setzt. Durch die Anbindung an vier PCIe-3.0-Lanes können Bildsignale (DisplayPort 1.2, Thunderbolt, HDMI 1.2) auch durch eine sogenannte Daisy Chain zum Monitor gelangen, bei dem die Monitore einen Ein- und Ausgang besitzen. Maximal lassen sich dann zwei 4K-Displays über einen Ausgang an der Grafikkarte ansteuern. Über Power Delivery können bis zu 100 Watt bereitgestellt werden, ein 10-Gbit/s-Ethernet lässt sich ebenfalls realisieren. Die hohe Datenrate erlaubt zudem den Anschluss einer externen Grafikkarte.

Ein deutlicher Nachteil sind die vergleichsweise großen Stecker, da mehrere Chips erforderlich sind. Zudem sind entsprechende Produkte noch recht teuer.

Ausblick

In den nächsten Jahren werden SSDs – auch wenn es aufgrund Lieferengpässen aktuell einen gewissen Preisanstieg gibt – deutlich günstiger werden. Da die Preise von Festplatten nahezu stagnieren, werden sich die Preise zunehmend annähern, was wiederum die Verbreitung der schnellen Flash Speicher weiter anheizen dürfte.

Ende 2016 konnte Micron zudem einen wichtigen Meilenstein verbuchen: Die auf 3D-TLC-NAND basierenden 5100er-Modelle sind mit Kapazitäten von bis zu acht Terabyte erstmals größer als Festplatten des jeweiligen Formfaktors.

Konsumenten werden sich bei der Anbindung externer Geräte in Zukunft wohl oder übel vermehrt mit USB Typ C auseinandersetzten müssen – ob nun in Form des reinen USB 3.1 SuperSpeed+ oder als Stecker für Thunderbolt 3. Letzteres dürfte einerseits im Notebook-Bereich aufgrund der geringeren Bauhöhe als Universalanschluss (etwa für Dockingsstationen) wie beim neuen MacBook Pro als auch im professionellen Umfeld deutlich häufiger werden.

Deutsch

Deutsch English

English Español

Español Français

Français Italiano

Italiano Nederlands

Nederlands Polski

Polski Português

Português Русский

Русский Türkçe

Türkçe Svenska

Svenska Chinese

Chinese Magyar

Magyar