Mrwhosetheboss prüfte in dem Video die vier KI-Modelle Grok (Version 3), Gemini (2.5 Pro), ChatGPT (GPT-4o) und Perplexity (Sonar Pro). Dabei betonte er durchgehend, wie beeindruckt er von Groks Leistung war. Grok legte einen starken Start hin, schwächelte zwischenzeitlich etwas, konnte sich aber wieder fangen und landete letztlich auf dem zweiten Platz hinter ChatGPT. Zur Fairness muss man hinzufügen, dass ChatGPT und Gemini einen Vorteil hatten: Sie konnten durch ein Feature punkten, das den anderen schlicht nicht zur Verfügung steht – die Videogenerierung.

Zu Beginn des Tests überprüfte Mrwhosetheboss die Fähigkeit der KI-Modelle, reale Probleme zu lösen, und stellte ihnen folgende Frage: „Ich fahre einen Honda Civic 2017. Wie viele Aerolite 29"-Hartschalenkoffer (79 x 58 x 31 cm) passen in meinen Kofferraum?“ Grok lieferte die einfachste und zugleich korrekte Antwort: „2“. ChatGPT und Gemini erklärten, dass theoretisch 3 Koffer hineinpassen könnten, praktisch aber nur 2. Perplexity hingegen lag deutlich daneben – es führte rein rechnerische Volumenberechnungen durch, vergaß dabei aber, dass es sich nicht um formlose Objekte handelt, und kam auf „3 oder 4“.

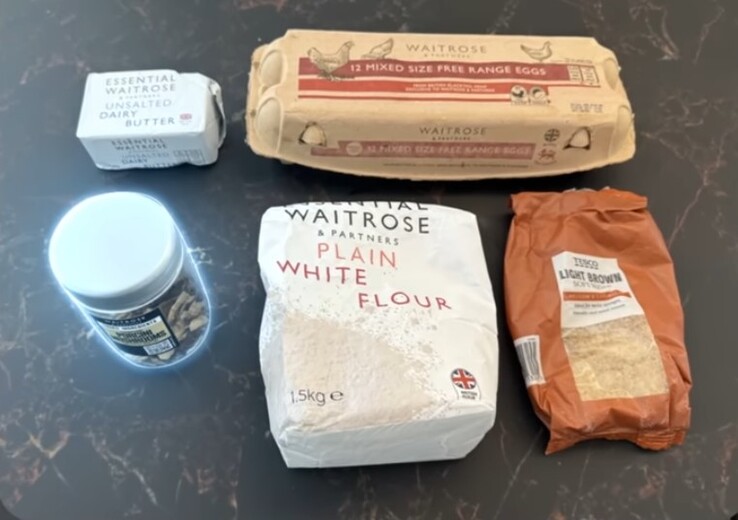

Bei der nächsten Frage ging er nicht gerade zimperlich mit den Chatbots um – er bat um Tipps zum Backen eines Kuchens. Dabei lud er ein Bild hoch, auf dem fünf Gegenstände zu sehen waren, von denen einer nicht zum Kuchenbacken passt: ein Glas mit getrockneten Steinpilzen. Bis auf ein Modell fielen alle auf den Trick herein. ChatGPT identifizierte das Glas als mit gemahlenen Gewürzen gefüllt, Gemini meinte, es handele sich um knusprig gebratene Zwiebeln, Perplexity nannte es Instantkaffee. Nur Grok erkannte korrekt, dass es sich um ein Glas mit getrockneten Pilzen von Waitrose handelt. Hier ist das Bild, das er hochgeladen hat:

Im weiteren Verlauf testete er die Modelle in den Bereichen Mathematik, Produktempfehlungen, Buchhaltung, Sprachübersetzung, logisches Denken und mehr. Eines war bei allen gleich: Halluzinationen. Jedes der Modelle zeigte an mehreren Stellen im Video eine gewisse Neigung dazu, also das Erfinden von Informationen, die schlicht nicht existieren, und zwar mit absoluter Überzeugung. So schnitt jede KI am Ende ab:

- ChatGPT (29 Punkte)

- Grok (24 Punkte)

- Gemini (22 Punkte)

- Perplexity (19 Punkte)

Künstliche Intelligenz hat viele Aufgaben deutlich erleichtert, besonders seit dem Aufkommen großer Sprachmodelle (LLMs). Das Buch KI Erfolgreich Einsetzen (aktuell 15,50 Euro auf Amazon) ist ein hilfreicher Leitfaden, um die Potenziale der KI besser zu verstehen und gezielt anzuwenden.