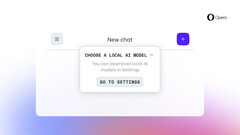

Nutzer von Opera One im Entwickler-Stream erhalten ein großes Update. Mit dem neuesten Update können Anwender LLMs herunterladen und lokal verwenden. Derzeit umfasst die Auswahl an Modellen mehr als 50 Familien und es gibt mehr als 150 verschiedene Modelle, die Benutzer herunterladen und auf ihren Computern ausführen können.

Einige bemerkenswerte Modelle sind Gemma von Google, LLaMA von Meta, Mixtral von Mistral AI und Vicuna von LMSYS. Diese neue Funktion wird im Rahmen des AI Feature Drops Program eingeführt. Das bedeutet, dass Nutzer, die die Entwicklerversion von Opera One verwenden, das Update testen können.

Opera ist derzeit der erste Webbrowser, der es seinen Nutzern ermöglicht, lokale LLMs herunterzuladen und zu verwenden. Für diejenigen, die sich fragen, ob diese Modelle lokal ausgeführt werden können, bietet dies oft volle Kontrolle, geringere Latenzzeiten und vor allem einen besseren Datenschutz. Allerdings muss Ihr Computer bestimmte Voraussetzungen erfüllen.

Beispielsweise gibt der Hersteller des Webbrowsers an, dass jede Variante des lokalen LLM mehr als 2 GB Arbeitsspeicher benötigt. Für die Ausführung der Modelle verwendet Opera nach eigenen Angaben das Open-Source-Framework Ollama. Das bedeutet auch, dass alle derzeit im Browser verfügbaren Modelle eine Untermenge der Ollama-Bibliothek sind. Die gute Nachricht ist, dass Opera plant, auch Modelle aus anderen Quellen zu integrieren.

Nicht alle Nutzer werden von diesem Update profitieren. Es ist jedoch eine gute Nachricht für diejenigen, die verschiedene LLMs lokal auf ihrem Computer testen möchten. Wenn Sie die Modelle nicht herunterladen möchten, können Sie den integrierten KI-Assistenten namens Aria verwenden. Er ist seit Mai letzten Jahres für die Standardversion des Browsers verfügbar (hier die KI-gesteuerte Webcam OBSBOT Tiny 2 bei Amazon kaufen).