Die Magie von Dall-E oder Stable Diffusion dürfte mittlerweile vertraut sein. Aus einer kurzen Beschreibung von Szene, Inhalt und vielleicht ein, zwei Anmerkungen entsteht ein mehr oder weniger realistisches Bild. Das lässt sich glücklicherweise meist als KI-generiertes Werk erkennen, erfüllt aber eben auch seinen Zweck: Ich muss nicht extra einen Hund auf ein Surfbrett stellen oder einen Fuchs in einen Astronautenanzug packen. Das gewünschte Bild ist nur ein paar Klicks entfernt.

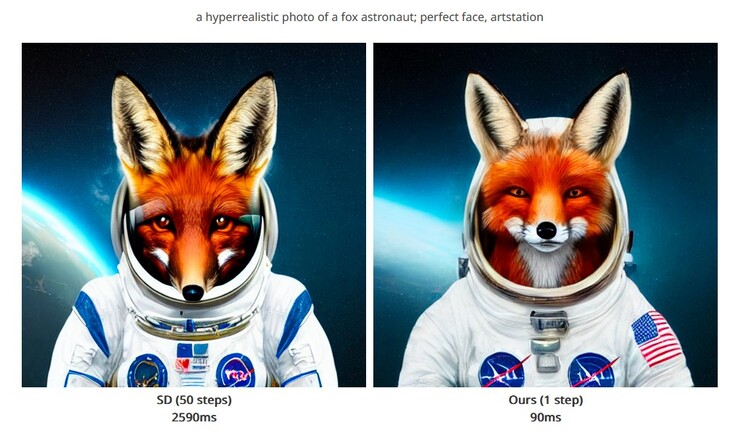

Im Hintergrund handelt es sich jedoch um einen rechenintensiven Prozess aus zahlreichen Iterationen, stetige Wiederholungen des Algorithmus, um schlussendlich auf das gewünschte Bild zu kommen. Forschenden am MIT ist es hingegen gelungen, auf diese zahlreichen Zwischenschritte zu verzichten. Stattdessen entsteht die beschriebene Szenerie nach genau einem Arbeitsschritt.

So lässt sich ein vergleichbares Ergebnis erzielen, während die nötige Rechenleistung oder die Wartezeiten deutlich sinken. Parallel dazu wird auch weniger Strom benötigt, um das System namens "Distribution Matching Distillation (DMD)" anzutreiben. Übersetzt bedeutet das ungefähr "Verteilungsgerechte Destillation".

Oder bildlicher ausgedrückt: Die für das Training genutzten Bilder werden in gröbere Bereiche zerlegt. Damit ist die ungefähre Bildkomposition je nach Motiv festgelegt. Zudem wird die Wahrscheinlichkeit für verschiedene Bildelemente analysiert, um am Ende eine stimmige Szene zu erhalten.

Im Endeffekt werden Detailinformationen reduziert, die Komplexität wird herabgesetzt, sodass der Bildgenerator schlicht schneller wird. Statt 2 bis 3 Sekunden pro Bild vergehen so mit der gleichen Hardware etwa 100 Millisekunden - ein Dreißigstel.

Schaut man die Bilder genau an, ist die Reduzierung von Details gut erkennbar. Hintergründe sind leicht verwaschen, Bildelemente können sich wiederholen. Die Motive können teils trotzdem deutlich besser aussehen und sind als Gesamtwerk dennoch einfacher als KI-generiert oder zumindest künstlich zu erkennen. Noch ein positiver Effekt.

Neben dem Fuchsastronauten finden sich hier viele weitere Beispiele des DMD-Modells.