Xiaomi: Roboter-Software für Jedermann verspricht starke Echzeit-Performance

Xiaomi ist sehr, sehr breit aufgestellt und bietet nicht nur etwa Smartphones und Tablets und sogar Autos an, sondern ist auch in der Robotik-Entwicklung aktiv. Mit dem Xiaomi-Robotics-0 hat das Unternehmen nun sein erstes Vision-Language-Action-Modell als Open Source veröffentlicht. Dementsprechend lässt sich dieses von Endnutzern nutzen, allerdings könnten auch andere Unternehmen auf Grundlage dieses Modells eigene Produkte realisieren.

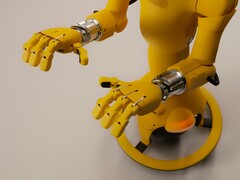

Das Modell wurde Xiaomi-Angaben zufolge auf Grundlage einer großen Datenbasis trainiert. Das Training erfolgt dabei zu einem großen Anteil mit beziehungsweise für die Nutzung mit zwei Armen. Werden Roboter mit zwei Armen genutzt, ergeben sich natürlich ganz neue Möglichkeiten. So können Objekte mit einem Arm gehalten und mit dem anderen manipuliert werden.

Auf Architektur-Ebene kommt ein vortrainiertes VLM zum Einsatz, dazu kommt ein Diffusion-Transformer für die Generierung von Aktionen. Dementsprechend wird unter Nutzung des auf Qwen3-VL-4B-Instruct basierenden Vision Language Models die Situation analysiert und dann werden entsprechende Aktionen generiert.

Wenig überraschend bewirbt Xiaomi ausführlich die Vorteile des Modells. So soll dieses die Echtzeit-Ausführung von Aktionen erlauben. Bewegungsabbrüche sollen kein Problem darstellen beziehungsweise besonders selten auftreten. Im spezifischen Libero-Benchmark wird Herstellerangaben zufolge ein Ergebnis von 98,7 Prozent erreicht. Für Interessierte steht ein von Xiaomi veröffentlichtes Paper bereit, zudem sind umfangreiche Ressourcen und das Modell selbst veröffentlicht worden.

Quelle(n)

Xiaomi, Foto von Enchanted Tools auf Unsplash