Das Acer Swift Go 16 AI welches wir vor kurzem im Test hatten, kommt mit AMD Ryzen 7 350 und 16 GB RAM. Der Zusatz AI im Namen soll zeigen, dass dieser Laptop für KI-Anwendungen bereit ist. Dafür scheint der Arbeitsspeicher in unserem Testgerät jedoch etwas knapp bemessen. Aber, KI-Modelle für Text, Bilder und Video werden immer leistungsfähiger und benötigen trotzdem weniger RAM. Auf dem Papier könnten im Arbeitsspeicher des Laptops damit einige interessante KI-Modelle laufen. Wir haben den Praxistest gemacht.

Windows 11 kommt in der neuesten Version selbst mit so einigen KI-Werkzeugen. Einige davon laufen lokal, andere laufen über Microsoft-Server. Leider ist nicht immer ganz klar, woher Copilot und Co. ihre Rechenleistung beziehen. Die Copilot-App verlangt immer eine aktive Internetverbindung. In der Fotos-App gibt es einige Funktionen, die lokal ohne Internetverbindung laufen, andere funktionieren nur in Verbindung mit einem Microsoft-Konto. Die Verbesserung der Bild- und Tonqualität von Webcam-Aufnahmen läuft lokal über die NPU. Auch das umstrittene Recall hat Microsoft ohne große Ankündigung wieder eingeführt. Es bleibt jedoch standardmäßig deaktiviert und lässt sich nur nutzen, wenn Geräteverschlüsselung und Passwortschutz eingerichtet sind. Viele weitere KI-Funktionen in Windows sind zudem nicht sonderlich auffällig oder funktionieren nur mit Microsoft Office.

Um andere Sprachmodelle und Bildgenerierung lokal zu nutzen, bedarf es spezieller Software. Allerdings ist der Weg, die Programme auf dem heimischen Rechner zum Laufen zu bekommen, bei weitem nicht mehr so umständlich wie noch vor einem Jahr. Mittlerweile gibt es für beides einfache Software, die schnell installiert ist und dem Anwender viele Möglichkeiten eröffnet. Mit Amuse steht eine Software für KI-Bildgenerierung und -bearbeitung bereit, die speziell auf die AMD-Hardware im Acer Swift Go 16 AI angepasst ist. LM Studio sorgt für eine komfortable Nutzung von LLMs also KIs zur Textgenerierung. FastFlowLM ist nicht ganz so komfortabel, läuft aber dafür energiesparend auf der NPU. Alle drei Programme haben wir auf unserem Testgerät installiert. Das Acer Swift Go 16 AI ist in der von uns getesteten Konfiguration mit 16 GB Arbeitsspeicher hier aber nicht gerade komfortabel ausgestattet. Windows und die vorinstallierten Programme von Acer fressen schnell sechs bis neun Gigabyte des knappen Arbeitsspeichers. Somit stehen für eine KI nur noch circa 10 GB Arbeitsspeicher zur Verfügung. Amuse stellt fest, dass etwa 8 GB Arbeitsspeicher nutzbar sind. LM Studio geht zunächst von 15 GB aus, stürzt aber jedes Mal ab, wenn man versucht, ein entsprechend großes Sprachmodell zu laden.

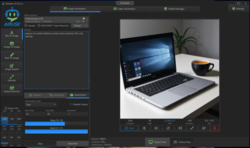

AMUSE - Bildbearbeitung und Generierung per KI

Amuse haben wir in der zum Testzeitpunkt neuesten Version (3.1) geladen. Die Software ist gratis und lässt sich komfortabel installieren. Die NPU von AMD-Prozessoren wird hier unterstützt, was das Arbeiten mit der KI deutlich beschleunigen sollte, auch wenn keine dedizierte GPU vorhanden ist. Neben der Text-zu-Bild-Generierung werden hier auch Bild-zu-Video und Bild-zu-Bild Funktionen geliefert.

Um überhaupt Bilder erzeugen zu können, muss man nach der Installation von Amuse auch noch die passenden KI-Modelle laden. Dies geschieht über das Programm und läuft recht komfortabel, benötigt aber etwas Zeit, denn einige Gigabyte wollen hier pro Modell auf die Festplatte gespeichert werden. Von den drei Voreinstellungen, die hier im Einsteigermodus geboten werden, funktioniert bei uns die Option „Balanced“ nicht. Fast und Quality laufen hingegen, wobei nur der schnelle Modus wirklich problemfrei läuft. Dieser setzt auf das kleine Dreamshaper LCM Turbo. Das passt gut in den begrenzten Arbeitsspeicher des Laptops und arbeitet wirklich schnell. Innerhalb von Sekunden werden hier Bilder generiert. Im Expertenmodus laufen auch StableDiffusion XL Turbo und StableDiffusion 3. Letzteres kann sogar auf die NPU ausgelagert werden. Aber beide Modelle nutzen den Arbeitsspeicher des Laptops voll aus und laufen zudem nicht wirklich schnell.

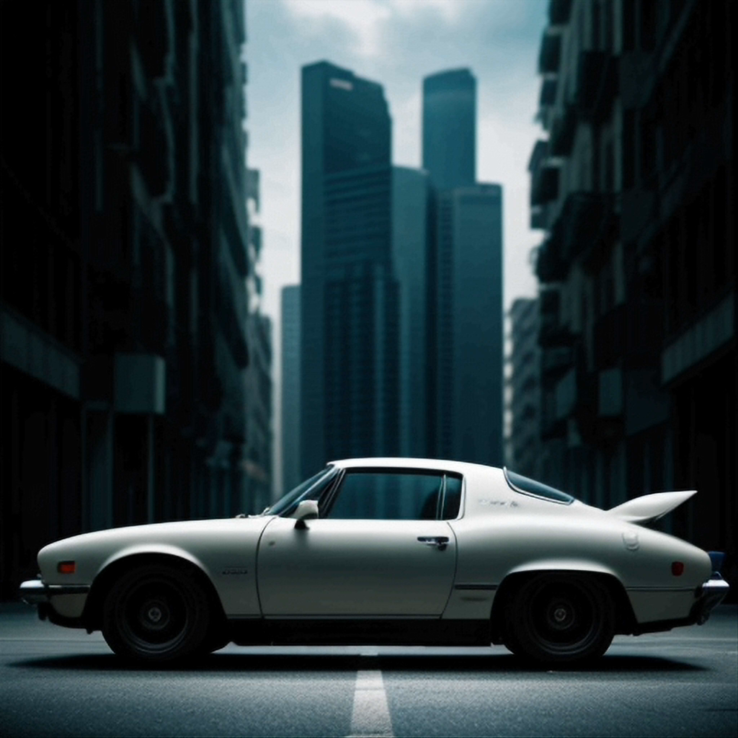

Gerade die Auslastung des Arbeitsspeichers wird hier zu einem echten Problem, denn sobald Amuse arbeitet, läuft nichts anderes mehr rund auf dem Laptop. Im Ernstfall stürzt sogar Amuse ab, sollte doch noch ein Browserfenster im Hintergrund zu viel Arbeitsspeicher einfordern. Spaß macht so nur der Einsatz des kleinen Dreamshaper LCM. Doch auch das liefert relativ gute Ergebnisse. Jedoch sind seine Wurzeln in Stable Diffusion 1.5 deutlich erkennbar. Verwaschene Kanten und seltsame Proportionen sind hier an der Tagesordnung, wenn man nicht genau auf die Prompts achtet. Dafür ist Dreamshaper LCM aber auch wahnsinnig schnell. Nahezu im Sekundentakt kann dieses Modell Bilder erstellen. Hier ist der Fokus dann Masse statt Klasse. Eines der Bilder wird schon halbwegs passen. Die Qualität kann man anschließend direkt in Amuse mit image2image-Bearbeitung verbessern.

LM Studio - Chatbots, Resoning Modelle und mehr

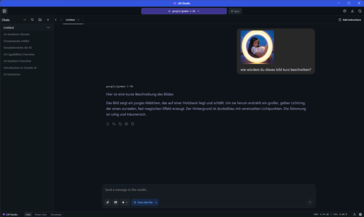

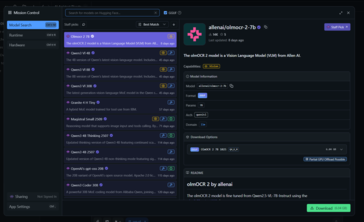

LM Studio ist ein Programm zum Verwalten und Ausführen von Sprachmodellen. ChatGPT, Llama, Qwen3 und andere können so lokal auf dem Laptop laufen. Wie bei Amuse scheint auch hier der limitierende Faktor des Acer Swift Go 16 AI eher der magere Arbeitsspeicher, als die Rechenleistung zu sein. OpenAI's neues gpt-oss 20B löst beim Laden einen Absturz aus. Für das Modell steht einfach nicht genügend Arbeitsspeicher zur Verfügung. Aus Erfahrung können wir bestätigen, dass das Modell tadellos auf Laptops mit AMD Ryzen 9 370 und 32 GB Arbeitsspeicher läuft.

Qwen3 Vi 8B, Qwen3 4B Thinking und IBMs Granite 4 H Tiny (Q4_K_M und Q8_0) liefen hingegen super auf dem Laptop von Acer. IBMs kleinstes Sprachmodell ist dabei überraschend schnell und glänzt mit guten Deutschkenntnissen. Qwen3 Vi 8B überzeugt mit einem sehr natürlichen Ton bei der Sprache und zeigt besondere Qualitäten bei der Verarbeitung von Bildern. Für Personen mit verringertem Sehvermögen könnte eine solche KI auf dem Laptop großartige Dienste leisten. Das Reasoning-Modell Qwen3 4B Thinking ist in unseren Versuchen das langsamste, wenn es um reine Textantworten geht. Aber vor allem die Antworten überzeugen hier. Je nach Komplexität der Frage können gerne mal fünf Minuten vergehen, bis man eine Antwort von Qwen3 erhält. Natürlich kann man während des Denkprozesses zusehen und könnte hier auch gleich dazwischengrätschen, wenn eine Antwort komplett in die falsche Richtung abdriftet.

Auch viele andere der kleinen Sprachmodelle dürften auf unserem Testgerät gut laufen. Allerdings frisst jedes Sprachmodell auch eine erhebliche Menge an Speicherplatz auf der SSD. Mit 3 bis 7 GB Platz muss man pro Sprachmodell rechnen. Die kleinen SLMs zeigen sich jedoch als überraschend vielseitig.

KI Unterwegs - FastFlowLM mit voller AMD-NPU-Unterstützung

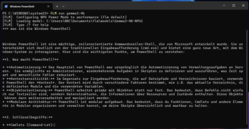

Wer unterwegs LM Studio nutzt, muss sich leider darauf einstellen, schnell einen leeren Akku zu haben. LM Studio zieht für alle Berechnungen CPU und GPU heran. Die sparsame NPU in unserem Ryzen 7 350 blieb ungünstigerweise komplett unangetastet. Mittlerweile gibt es auch dafür Abhilfe. Mit FastFlowLM kann man die NPU-Leistung des AMD-Chips nutzen. Damit verbunden ist eine deutlich geringere Energieaufnahme, obwohl die LLMs auf der NPU nicht merklich langsamer laufen. Auch die Qualität der Ausgaben unterscheidet sich nicht. Aber FastFlowLM ist etwas schwieriger zu nutzen als LM Studio, da es keine eigene grafische Nutzeroberfläche mitbringt. Mit Open WebUI kann man FastFlowLM jedoch komfortabel im Browser nutzen. Sonst muss man sich auf die Windows Powershell beschränken. Das sieht unter umständen aber auch mal ganz interessant aus, wenn sich die Powershell wie von Zauberhand mit viel Text füllt.

Zum Vergleich haben wir die Energieaufnahme des Laptops bei der Nutzung von Gemma3:4b mit LMStudio und FastFlowLM verglichen. Mit FastFlowLM lag die maximale Leistungsaufnahme des Laptops bei rund 25 Watt. Deutlich mehr war es bei der Nutzung des gleichen Modells per LM Studio. Hier haben wir eine Leistungsaufnahme von rund 65 Watt gemessen. In beiden Fällen lag die Ausgaberate (in Tokens pro Sekunde) jedoch deutlich über 10 Tok/s. Je nachdem, wie man das umrechnen mag, kommt ein Sprachmodell damit auf etwa 250 bis 600 Wörter pro Minute. Nach Faustregel sind 1,8 Token ein deutsches Wort, 1,3 Token ein englisches Wort. Wir haben die von Gemma verfassten Texte analysiert und sind auf rund 450 Wörter pro Minute in FastFlowLM und 600 Wörter pro Minute in LM Studio gekommen. Beides ist deutlich schneller, als ein durchschnittlicher Leser.

Fazit - Lokale KI ist möglich aber nicht immer sinnvoll

Die Windows-KI funktionen laufen auf dem Acer Swift Go 16 AI tadellos. Überraschend schnell stehen auch die Antworten von SLMs wie Gemma3, Qwen3 und Granite 4 auf dem Bildschirm. Je nach Modell mal mit mehr oder weniger hoher Qualität. Wer unbedingt Text2Image-Modelle und andere Funktionen von Amuse nutzen möchte, sollte wohl lieber zu einem Laptop mit mehr Arbeitsspeicher greifen. Das Acer Swift Go 16 AI gibt es auch mit 32 GB RAM.

Letztlich steckt KI leider noch immer in den Kinderschuhen. Eine Software, die einfach zu bedienen ist, und die Fähigkeiten der AMD-NPU nutzt, gibt es weiterhin nicht. Schade, denn die Leistung, die wir mit den kleinen Basteleien aus dem Laptop von Acer ziehen konnten, war gerade bei den Sprachmodellen hervorragend. Auch Amuse zeigt ein gutes Potenzial auf dem Laptop, wirft aber für unseren Geschmack deutlich zu viele Fehlermeldungen und ist teils auch recht langsam.

Unsere Tests zeigen primär: Wer KI-Funktionen sinnvoll nutzen will, braucht viel Arbeitsspeicher, der möglichst schnell angebunden ist. Denn eine KI allein nutzt meist nicht viel. Browser oder Word sollten nebenbei auch flüssig laufen können.