Der Fall von Melissa Sims hat gezeigt, wie gefährlich ungeprüfte KI-Inhalte im Rechtssystem sein können. Die Industrie verspricht Abhilfe in Form von sogenannten "AI Detectors" – Software, die mithilfe komplexer Algorithmen erkennen soll, ob ein Bild von einem Menschen oder einer Maschine stammt. Doch wie zuverlässig sind diese digitalen Spürhunde wirklich, wenn man es darauf anlegt, sie zu täuschen? Wir haben ein Experiment gewagt und sechs der aktuell gängigsten Erkennungsdienste auf die Probe gestellt. Zunächst haben wir mit einigen echten Bildern experimentiert und dabei herausgefunden, dass einige handgeschossene Bilder bei bis zu 10 % KI-Wahrscheinlichkeit landen.

Update: Im zweiten Teil unserer Serie betrachten wir, wie man das KI-Bild mit bloßem Auge entlarvt.

Update: Ob Googles SynthID sich knacken lässt, haben wir im dritten Teil unserer Serie untersucht.

Das Testobjekt: Ein leicht absurdes Szenario

Um die Tools herauszufordern, nutzten wir den Google-Gemini-Bildgenerator „Nano Banana Pro“. Unser Prompt war bewusst simpel, aber ein wenig skurril: „Eine Frau, die in kämpferischer Pose eine Banane gegen den Himmel streckt. Im Hintergrund eine typische Stadtlandschaft mit uninteressierten Menschen.“

Das erste Problem für die automatischen Tools zur Erkennung von KI-erstellten Bildern ist hier schon das verwendete Modell selbst. Nano Banana Pro ist recht neu am Markt. Einige der Erkennungsdienste suchen speziell nach den Anzeichen von Midjourney, Dall-E3, StableDiffusion, Flux und anderen Modellen. Dafür müssen sie besonders trainiert sein. Letztlich handelt es sich bei den Detektoren nämlich meist auch um Tools aus dem Bereich des maschinellen Lernens. Ein recht neues Modell wie Nano Banana Pro ist von daher im Vorteil, da es keine bekannten Fingerabdrücke hinterlässt.

Runde 1: Das Scheitern trotz Wasserzeichen

Im ersten Schritt machten wir es den Detektoren eigentlich leicht. Das Bild wurde direkt aus dem Generator genommen. Wir konvertierten das ursprüngliche PNG lediglich in ein JPG-Format und entfernten die Metadaten. Entscheidend war: Das Bild enthielt noch ein deutlich sichtbares Wasserzeichen von Gemini.

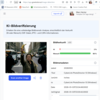

Man sollte meinen, dass ein sichtbares KI-Branding für Erkennungssoftware ein Elfmeter ohne Torwart ist. Das Ergebnis war jedoch ernüchternd: Bereits in diesem Rohzustand versagten zwei der sechs getesteten Tools. Trotz des offensichtlichen Wasserzeichens stuften sie die Wahrscheinlichkeit, dass das Bild KI-generiert sei, als gering ein.

Runde 2: Der digitale Radiergummi

Im zweiten Schritt näherten wir uns einem realistischen Fälscher-Szenario an. Das verräterische Wasserzeichen musste weg. Der integrierte AI-Radierer der Windows-Fotoanzeige erledigte den Job in Sekunden sauber.

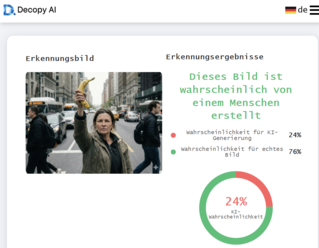

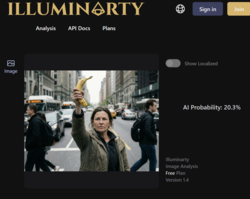

Das Ergebnis dieses minimalen Eingriffs war sofort messbar: Ein weiteres Tool ließ sich täuschen und stufte die KI-Wahrscheinlichkeit nun als gering ein. Aber interessanterweise stufte Illuminarty die Wahrscheinlichkeit für ein KI-generiertes Bild nun höher ein. Trotzdem: drei der sechs Tools zur KI-Bilderkennung geben eine Wahrscheinlichkeit von unter 30 % an, dass es sich bei der Frau mit Banane um eine KI-Schöpfung handelt.

Runde 3: Die Perfektion der Unvollkommenheit

Im finalen Test schauen wir, was der „technisch versierte Fälscher“ zustande bekommt. KI-Bilder sind oft „zu glatt“, zu perfekt in ihrer Farbverteilung und weisen ein uniformes Rauschen auf. Um die Detektoren endgültig in die Irre zu führen, mussten wir dem Bild etwas „künstliche Realität“ verleihen – also typische Fehler der digitalen Fotografie hinzufügen.

Mithilfe von Cyberlink PhotoDirector (ab 56 Euro auf Amazon) wurde das Bild nachbearbeitet. Wir fügten eine leichte Linsenkorrektur hinzu (die paradoxerweise optische Verzerrungen simuliert), erzeugten künstliche chromatische Aberration (Farbsäume an Kanten), erhöhten den Kontrast und sorgten mit der Rauschreduzierung für ein verändertes Rauschverhalten im Bild. Das Ziel war es, das Bild wie eine Aufnahme aus einer echten, unvollkommenen Kamera aussehen zu lassen. Das Ganze hat uns nur wenige Klicks abverlangt. Innerhalb von nicht einmal fünf Minuten war das Bild maskiert.

Original und Nachbearbeitung im Vergleich

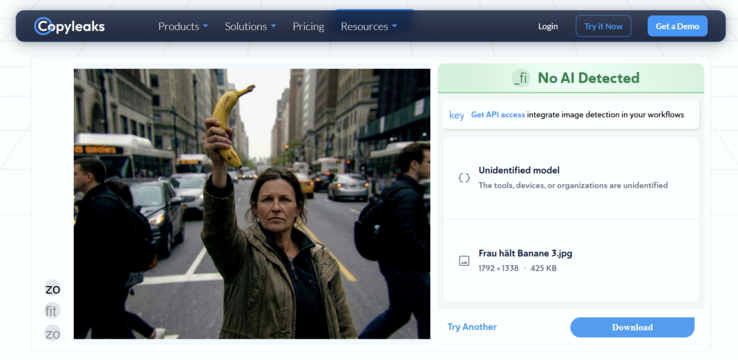

Das Ergebnis von Runde 3 war ein Totalausfall der Erkennungstechnik. Nachdem das Bild diese Standard-Nachbearbeitung durchlaufen hatte, kapitulierten alle getesteten Dienste. Kein einziges Tool gab eine Wahrscheinlichkeit von mehr als 5 Prozent an, dass es sich um ein KI-generiertes Bild handeln könnte. Für die Software war die Frau mit der Kampfbanane nun zweifelsfrei ein echtes Foto.

Fazit: Ein gefährliches Gefühl der Sicherheit

Unser Experiment zeigt drastisch auf, dass die aktuellen technischen Lösungen zur KI-Erkennung noch in den Kinderschuhen stecken. Wenn wenige Minuten und handelsübliche Bildbearbeitungssoftware ausreichen, um die Erkennungsraten von „sehr wahrscheinlich“ auf „unter 5 Prozent“ zu drücken, sind diese Tools für den Einsatz vor Gericht, in Redaktionen oder bei der Polizei derzeit nicht nur nutzlos, sondern gefährlich. Sie suggerieren eine Sicherheit, die faktisch nicht existiert. Das Prinzip „Vertrauen ist gut, Kontrolle ist besser“ funktioniert nur, wenn die Kontrolleure nicht blind sind.

Dass man mit bloßem Auge doch einige Fehler erkennt, zeigen wir im zweiten Teil des "Nano Banana Pro"-Experiments. Googles eigenes Werkzeug um Bilder von Nano Banana Pro zu erkennen haben wir im dritten Teil unserer Serie untersucht.